【ナゾロジー×産総研マガジン 未解明のナゾに挑む研究者たち】「初音ミクも研究対象!未来の音楽体験を作る研究」

【ナゾロジー×産総研マガジン 未解明のナゾに挑む研究者たち】「初音ミクも研究対象!未来の音楽体験を作る研究」

【ナゾロジー×産総研マガジン未解明のナゾに挑む研究者たち】「初音ミクも研究対象!未来の音楽体験を作る研究」

2024年2月21日掲載

取材・文 海沼賢, ナゾロジー編集部

技術系の研究は、専門的で難しい話になりそうなイメージを持つ人がいるかもしれません。

しかし新しい技術は私たちの身近なエンタテイメントの世界でも活躍しています。

例えば音楽は、昔はレコードやカセットテープ、CDなどのメディアに記録され、それらを聴くのが一般的でした。しかし、今やほぼ全ての音楽がデジタル化されて、世界中の何千万曲という音楽を定額サービスでネット上から聴き放題で楽しめるようになりました。

これ自体も技術による大きな変化ですが、そうやって膨大なデジタル音楽に誰でも触れられるようになると、そこには音楽を創る側にも聴いて楽しむ側にも、今までとは全く異なる音楽との関わり方や楽しみ方が生まれてきます。

バーチャルライブなどの仮想空間と繋がった新しい音楽ライブ、大量の音楽から好みの曲を見つける方法、手間のかかる音楽動画を簡単に創る方法、こうしたエンタテイメントに関わる技術の数々も、いきなり発展するわけではなく、SFのような未来を予想して何十年も前から準備してきた研究者たちのおかげで、私たちは利用することができるのです。

ナゾロジーと産総研マガジンのコラボ企画第二弾は、そんな音楽体験の未来を切り拓く研究者 産業技術総合研究所(産総研)首席研究員 後藤 真孝さんにお話しを伺います。

研究者たちは、一体どのように未来を捉え、どんな新しいワクワクする音楽体験を作っていくのでしょうか?

こちらの記事は、科学を好きな人を増やすメディア、ナゾロジーでも同時公開されています。ナゾロジーの記事はコチラ!

「もっと能動的に音楽を楽しむ」未来の音楽体験にまずは触れてみよう!

――後藤さんの研究チームの仕事は色々なところで紹介されていて、たぶん何かしらの形で触れたことがあるって人も多いのではないかと思います。ニコニコ動画のニコニコ大百科に「産総研P」ってボカロP(プロデューサー)が登録されていますけど、その中の人たちは後藤さんの研究チームですよね。

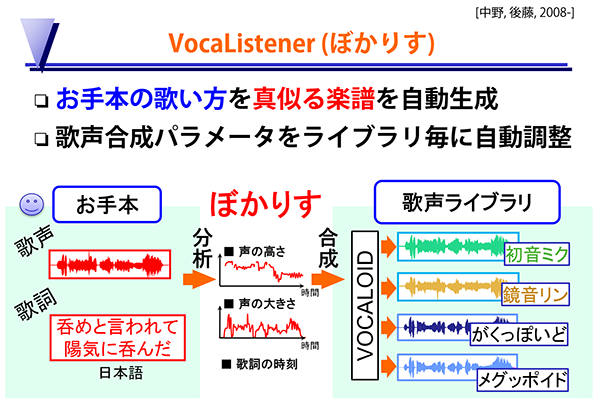

後藤そうですね。「産総研P」と自分たちから名乗ったことはないんですけど、2008年にユーザーの歌い方を真似して初音ミクが自然に歌えるという技術「VocaListener(ぼかりす)」のデモ動画を、「【初音ミク】 PROLOGUE 【ぼかりす】」というタイトルでニコニコ動画に投稿したのがきっかけです。

――これ発表されたとき私も「すげぇ」って笑って見てたのを覚えています。初音ミクがすごく人間臭く演歌を歌ってる動画「【初音ミク】 大漁船 【ぼかりす】」も投稿していましたよね。これ以外にも、ボカロ楽曲やニコニコ動画と連動した研究を色々出されているので、後藤さんのことは「初音ミクの研究をしてる人」と認識している方も多いかもしれないですね。

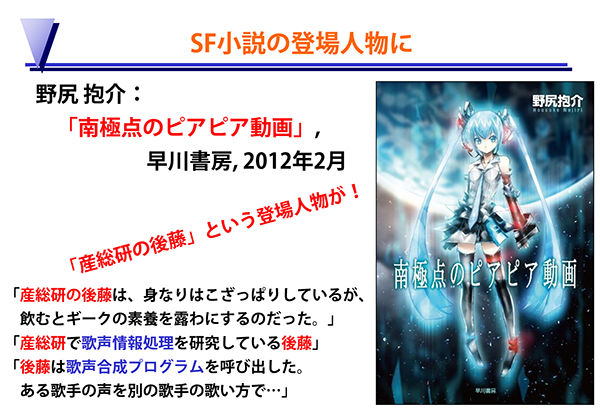

初音ミクをモデルにした「南極点のピアピア動画」というSF小説の中にも、「産総研の後藤」というキャラクターが出てくるんですよね。

後藤そうなんです、これは本当に嬉しくて。事前に知らされていなかったので、後から知って驚きました。

SF小説「南極点のピアピア動画」には「産総研の後藤」というキャラクターが登場する

SF小説「南極点のピアピア動画」には「産総研の後藤」というキャラクターが登場する

――あれ、知らないうちに出てたんですね(笑)

後藤あるとき自分がSF小説に出ているとしか思えないツイート(ツイッター上の書き込み)を見つけて。買って読んでみたら本当に「産総研の後藤」が主人公の一人として登場していてびっくりしました。著者の野尻先生とは情報処理学会でお会いしたことはあったのですが、おそらく、私は無断でも喜ぶだろうと見抜かれていたんだと思います(笑)。

――そんなユニークなお話しもある後藤さんですが、研究分野はどういうものになるんでしょうか?

後藤いろいろと取り組んでいるんですけど、本日お話しようと思っているのは「音楽情報処理」という研究分野です。これは、コンピュータで音楽のあらゆる側面を扱う分野で、学生の頃から31年間取り組んでいて、私が非常に愛している研究分野です。

音楽配信とか楽曲の検索とか、今話題に出た歌声合成もそうですし、音楽を鑑賞する人たち、創作する人たちの支援なども含むとても幅広い分野です。

特に今回は、コンピュータが音楽を解析する「音楽理解技術」にフォーカスして、音楽情報処理の力でこんな面白い事が可能になる、ということをお話しできればと思っています。

――後藤さんたちの研究ってウェブサービスとして公開されていて、すぐに読者にも触ってもらえる面白い成果がすでにたくさんあるんですよね。

後藤そうですね。私たちはただ論文を書くだけじゃない研究アプローチを目指しています。技術の力で未来を切り拓くって考えた場合、企業と連携するのはもちろん正攻法で私たちもやっていますけど、最新技術を皆さまにいち早く使ってもらえるように、研究者自らがウェブサービスやプラットフォームを研究開発して公開するということに挑戦しています。

――私は先にいろいろ見せていただいたんですが、そのウェブサービスっていうのは、URLに接続するだけで誰にでも触ってもらえるんですよね。なのでここはウェブ記事の強みとして、まず後藤さんたちが公開している研究成果の一部を読者の方たちに触ってもらって、「なにこれ、すごい!」って驚かせてから中身の技術や研究の話をしていきたいと思います。

私は見せていただいた中で、歌詞付きのPVが簡単に作れてしまうってサービスが非常に驚いたんですけど。

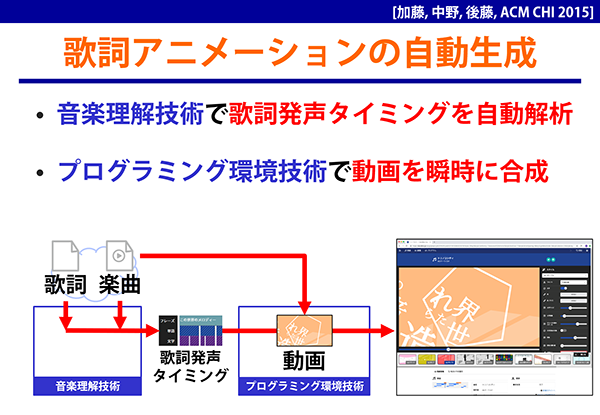

後藤「TextAlive(テキストアライブ)」ですね。これはリリックビデオ(歌詞アニメーション)の制作支援サービスです。リリックビデオというのは音楽に合わせて歌詞が踊るように動くアニメーションが表示される動画のことで、近年、目にすることも多い人気のある演出です。

※「TextAlive」リンク こちらをクリックして体験してみてください

音量に注意

(画像下部にある「キュート」とか「グラデーション」というスタイルボタンをクリックすると歌詞アニメーションが変化します。右のメニュー(スマホはページの一番下部)では歌詞のフォントも自由に変えられます。)

「TextAlive」の画面。画像をクリックしても「TextAlive」が体験できます。

「TextAlive」の画面。画像をクリックしても「TextAlive」が体験できます。

後藤ここで表示されているリリックビデオは既存の動画を見ているわけじゃなくて、ウェブブラウザ上で実行されているプログラムがリアルタイムに生成している映像なんです。なので見ながら編集もできます。YouTubeなどの動画再生とはまったく違う体験になっています。

普通はリリックビデオを作るには、歌詞の1文字1文字のタイミングを人手で設定して演出もつける必要があって大きな手間がかかります。でもTextAliveを使えば、コンピュータが音楽を解析することで歌詞の表示タイミングなどを自動で設定してくれるので、手軽にいろいろなリリックビデオが作れるんです。

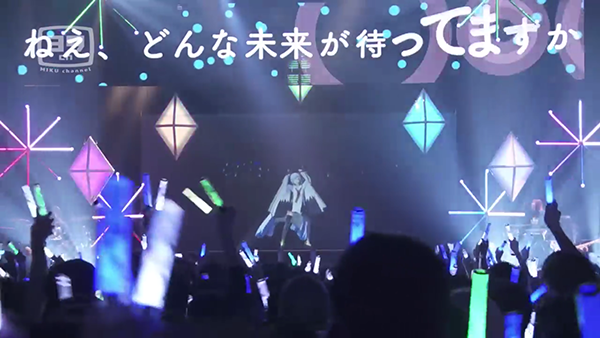

――私これ見たときライブとかの演出に使えそうとか思いましたが、実際すでに初音ミクのライブとかプリキュアのライブ背景で流れているリリックビデオにこのTextAliveの技術が使われたことがあるんですよね。

後藤そうです。例えば、初音ミクの公式ライブ「SNOW MIKU LIVE! 2018」で画面の上に流れている歌詞がそうですね。

「SNOW MIKU LIVE! 2018」の様子。画像をクリックすると実際のライブの場面が視聴できます。

「SNOW MIKU LIVE! 2018」の様子。画像をクリックすると実際のライブの場面が視聴できます。

後藤プリキュアはVR空間の中のバーチャルライブなんですが、最近、VRライブの演出で利用いただく事例が増えてきました。もちろん、TextAliveでPVを付けたオリジナル楽曲もいろいろなクリエイターの皆さまが公開しています。

――この時点でも驚く人は多いと思いますけど、「TextAlive」自体は結構前の成果で、ここから更に新しい試みをされているんですよね。

後藤そうです。TextAliveでいろいろ編集はできますが、最終的にでき上がるものは動画なんです。でも未来ではインタラクティブに毎回違う体験が当たり前になると私たちは考えました。そこでリリックビデオの次世代の姿として、世界初の「リリックアプリ」という新概念を提案しました。これは音楽に合わせてタイミングよく歌詞が動く音楽アプリで、それをプログラマーの皆さまが自由に開発できるプラットフォーム(API)を開発して公開したんです。

これを使うと何ができるかって言うと、例えばマウスで画面をなぞっていくとそれに合わせて歌詞が追いかけて表示される音楽体験ができるようになります。ユーザーがマウスをどう動かすかによって歌詞の出方がぜんぜん違うので、PVと違って二度と同じ画面が表示されず、自分専用の演出を楽しめます。

――これスマホだと指でなぞって遊べるんですね。

後藤そうです。パソコンでもスマホでも誰でも無料で試せます。これは見ているだけだとわからないかもしれませんが、自分で触ってみるとすごく面白い体験なんです。なのでぜひ実際に触って、これが未来の音楽体験かって感じてもらえればと思います。

※「リリックアプリ」のリンク こちらをクリックして体験してみてください

(リンク開くと真っ白な画面が出るので、白い画面のところをクリック(タップ)するとアプリが始まります。右下の小さい動画画面は触らないでください)

リリックアプリの画面。画像をクリックすると実際にアプリが体験できます

リリックアプリの画面。画像をクリックすると実際にアプリが体験できます

――これ確かに音に合わせて自分のなぞった場所に歌詞がでてきて、ただ聴くのとは全然違った体験に感じられますね。で、さらにこの技術を使ってプログラミングコンテストも開かれたとか。

後藤私たちはあくまで裏方なので、APIを整備してみんながリリックアプリを開発できるように提供しています。その「TextAlive App API」を使ったリリックアプリのプログラミングコンテストを、初音ミクで有名なクリプトン・フューチャー・メディア株式会社が、2020~2023年に4回実施してくださいました。いろんな方に応募いただけて私たちも驚くようなアプリが次々と登場しています。

コンテストの公式サイトでは4年間の入選作品40作品(2020年、2021年、2022年、2023年)がパソコンやスマホで遊べるように公開されているので、ぜひ体験してみてください。本当に面白くって、「あ、音楽でこんな事ができるんだ」って未来を感じてもらえると思います。

――ちょっといくつかピックアップしてもらおうかなと思うんですけど。

後藤そうですね、例えばリリックビデオとはまったく違うことをわかっていただくために、2023年の入選作品の中でゲームっぽいのだと、このエントリーNo.2の「りりっくぼーる」は、簡単に遊べて、なるほど!ってわかると思います。

※「りりっくぼーる」を試す

――あ、すごい。これ歌詞がピンボールになって飛び出してくるんですね。しかもちゃんとスコアもついてて。これ、わけの分からない凄さを感じますね(笑)こう来るとは思わなかったです。

後藤あと、最優秀賞になったのがエントリーNo.6の「Miku SNS」というもので、これはSNSの投稿画面で、歌詞が一行ずつ歌われるタイミングで表示されます。この歌詞の投稿それぞれに「いいね」ができたり、返信できたりするだけでなく、自分でも自由にメッセージを投稿できるんです。

※「Miku SNS」を試す

――楽しい!これすごいですね!

後藤しかも、歌詞の投稿に返信をしている他のSNSユーザーにもちゃんと人物設定がされていて、クリックするとその人の過去の投稿も見れたりするんです。すごく作り込まれてます。

――これってPVの演出とかにありそうなのに、本物のSNSアプリみたいに使うことができるんですね。これはまさに触れる未来のPVですね。

後藤あとカメラが利用できるなら、優秀賞になったエントリーNo.9の「lyric-from-mouth」を試してみてください。

ウェブブラウザでカメラを有効にすると、画面内の自分の口から歌詞が飛び出してくるんです。口を開ける大きさで飛び出す歌詞の文字サイズも変わったりして、これやってみるとわかるんですが、人生で初の音楽体験になると思います。

※「lyric-from-mouth」を試す

――ほんとにこれは面白い!確かに未来を感じます。これもうこのサイトで一日中遊べちゃいますね。

後藤他にも素晴らしい作品がいろいろと公開されているので、ぜひ体験してみてください。

私たちは未来にリリックアプリの概念が普及することを確信していて、ここでプログラマーの皆さまが応募した斬新な作品も、形を変えて未来には当たり前の音楽体験になっているのだと思います。なので、今、リリックアプリを体験した方は、将来そのアイデアが流行ったとき、あのプログラミングコンテストの作品が世界初だったんだ!のように思い出していただけるかもしれません。

――もうこの時点で、未来の音楽体験を作る技術という研究がすごいなって分かってもらえると思うんですけど、ここまでは今回の記事の掴みにするために、後藤さんたちの研究に関してちょい見せしてもらっただけでして、ここからはなぜこんな事ができるようになったのか?という研究の中身について伺っていきたいと思います。

コンピュータが音楽を自動解析する「音楽理解技術」の研究

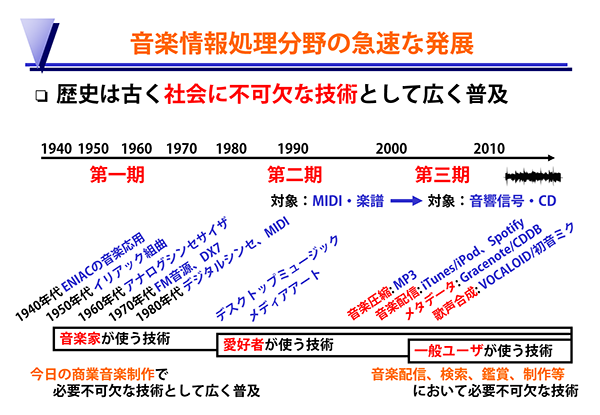

――音楽をコンピュータで扱うとなると比較的新しい分野なのかなという印象を抱きますけど、こういった音楽情報処理の研究っていつ頃からあるんですか?

後藤実は音楽情報処理の研究の歴史は古くて、コンピュータの発明とほぼ同時期の1940~1950年代には取り組まれていました。

――え? そんな昔からあるんですか。その頃ってどういうことをやっていたんですか?

後藤自動作曲をする試みが初期は多くて、その後、シンセサイザのようなデジタル楽器やデジタル録音環境といった、現代の音楽制作にはなくてはならない技術が生まれていきました。

当初は一部の音楽家が使う技術として研究されていたんですが、1980~1990年代に入って家庭にもパソコンが普及するようになると、趣味で音楽を楽しむ人たちも使う技術になっていきます。私も当時、パソコンで音楽制作をして遊んでいました。

音楽情報処理分野の歴史

音楽情報処理分野の歴史

――ああ、その辺からデスクトップミュージック(DTM)みたいな言葉も聞くようになった感じがしますね。ただ、かなりマニアックな印象でしたね。

後藤その後、1990年代の後半に音響圧縮技術のMP3が普及して、2000年以降にMP3プレーヤーや音楽配信が普及するとガラッと雰囲気が変わって、一般の人たちが音楽を楽しむ手段としてパソコンが当たり前のものになっていきました。

――確かに初代iPodの発売が2001年10月でしたね。もう若い人にはiPadを書き間違えてますよって言われちゃいそうですけど。

後藤なので歴史は古いですが、音楽情報処理が社会に不可欠な技術として一般的に広く普及するようになったのは2000年以降で、それから20年の間に世界中で研究者も増えて、大きな研究プロジェクトも次々と立ち上がる分野になっていきました。

こうしてすべての音楽がデジタル化されて、創作したり、配信されたり、聴いたりすることが当たり前になったんです。

――漫画なんかもみんな手で描いていたのが、今は鳥山明もデジタルで描いてるみたいな話を聞くのと似た感じですね。

後藤ただ、その結果、アクセスできる楽曲の数が膨大になりました。昔はCDショップの店頭に並んでいたり、テレビやラジオ、ライブで流れたりする音楽しか聴けなかったのが、過去の数十万~数千万曲をいつでもどこでも聴ける時代になったわけです。

こうして沢山聴けるのは嬉しい反面、知っている曲名やアーティスト名で検索するだけでは、好みの音楽を見つけられません。もしみんなが探すのを諦めて、ランキングに上がるヒット曲しか聴かないと、誰かの好みに合う新曲が生まれても聴いてもらえない問題が起きて、音楽の多様性も失われかねません。しかもアクセスできる楽曲は増え続けるので、未来に出る新曲ほど埋もれやすくなってしまうんです。

――確かに、音楽は映画などを探すのと違って視覚的な手がかりも乏しいですし、映画や小説と比べても数が膨大になりますよね。触れられる曲が膨大になった以上、探す方法や聴き方にも変化が起きないと新しい曲との出会いが制限されてしまうんですね。

後藤なので、これからの時代はこの膨大な楽曲を何らかの方法で出会いやすいように変えていく必要がある。人々の音楽体験は過去も技術の力で変化して来ましたが、未来においても技術の力で助けてもらいたいわけです。

――なるほど。音楽がデジタル化されて膨大なデータになったことで、私たちの音楽との接し方はどんどん変化していくことになる。それが最初に少し見てもらった未来の音楽体験という部分にも繋がって行くんですね。

後藤そのための音楽情報処理の研究にはいろいろな成果がありますが、特に、私が31年間取り組んでいるのが「音楽理解技術」です。

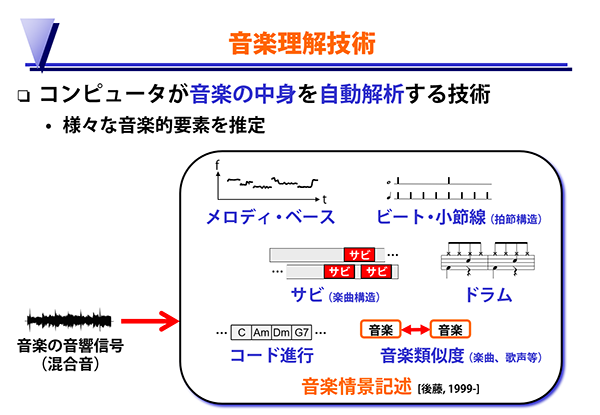

音楽というのは色々な音が混ざった音響信号で、その音楽の中身をコンピュータで自動解析して、メロディやベース、ビート、サビ、ドラム、コード進行のようないろいろな音楽的要素を取り出そうというのが、この技術の基本的な部分です。

ただ人間なら聴けばわかっても、コンピュータが自動的に求めるのは難しかったんです。

コンピュータが音楽の中身を自動解析する「音楽理解技術」

コンピュータが音楽の中身を自動解析する「音楽理解技術」

――確かに私たちも「この曲サビがいいね」とか良く言いますけど、じゃあ「サビってなんだ?」って聞かれると「一番盛り上がるところ…?」とか曖昧にしか答えられないですね。そんなニュアンスは機械には当然通じないし、機械にサビを理解させようとしたらどうすればいいのかちょっと想像できないですね。

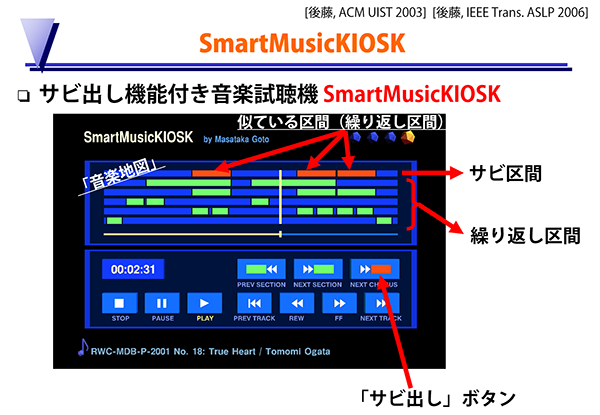

後藤そうしたサビを自動検出して、さらにその結果で何か役立つことができないか、と考えて20年くらい前に研究開発したのが、音楽試聴のための「SmartMusicKIOSK(スマートミュージックキオスク)」というシステムです。

「SmartMusicKIOSK」の画面。画像をクリックするとデモ解説を視聴できます。

「SmartMusicKIOSK」の画面。画像をクリックするとデモ解説を視聴できます。

これは一番上のオレンジ色の区間がサビの繰り返しを表していて、それ以外の緑色の区間はサビ以外の繰り返し構造を表しています。それぞれの区間がボタンになっていて、クリックすると再生できます。右下には「サビ出し」ボタンもあって、曲の頭からではなく、いきなりサビから聴けます。これは沢山の楽曲の中から自分好みの曲を見つけるような試し聴きをするときに非常に便利で、サビを聴いて気に入ったら、一曲を通して聴く、みたいな聴き方が可能になります。

――なるほど。さっきの膨大な音楽から好みの楽曲を見つける、みたいな話につながってきますね。

後藤このシステムでは、ポピュラー音楽の曲中で転調したり伴奏が変化したりしても、サビの繰り返しを見つけることを世界で初めて可能にしました。これは技術的には結構すごいことで、転調して音の高さが変わったり、歌の伴奏が大きく変化したりすると音響信号的にはまったくの別物になってしまう難しさがあります。それに対処して曲の中の繰り返しを見つけ、サビを検出できているんです。

――さっきもサビって聴けば分かるけど、何なのかわからないという話をしましたが、これはどうやってコンピュータにサビを理解させたんですか?

後藤音量が大きかったりメロディの音が高かったりすればサビ、というわけではないので、SmartMusicKIOSKでは、楽曲中の繰り返し構造に着目しています。さきほどの画面で、いろいろな緑色の区間の繰り返しがありましたが、それらをまずはサビの候補として見つけます。次に、サビは曲の中でも一番聴かせたい部分なので最も繰り返される、ということを仮定して、そういう区間のサビらしさを高く評価します。他にも、サビには構造的な特徴があって、ある繰り返し区間の中でその半分の長さでさらに2回繰り返される区間や、曲の1番2番みたいな長い繰り返し区間の最後に出てくる繰り返し区間は、サビらしさが増すという処理も入っています。

そういった要素をいろいろと考慮して、サビ区間を求めています。

――確かにこうなるとただのシークバーと違って、曲の中身が一気にわかりやすくなって聴きやすい感じがしますね。

後藤そうですね。従来はこのように何もないシークバーが表示されるだけでした。これだと初めて聴く曲の場合、どんな構造でどの位置で何が起きているのかさっぱり分かりません。

従来のシークバーだけでは曲の構造について何もわからない。

従来のシークバーだけでは曲の構造について何もわからない。

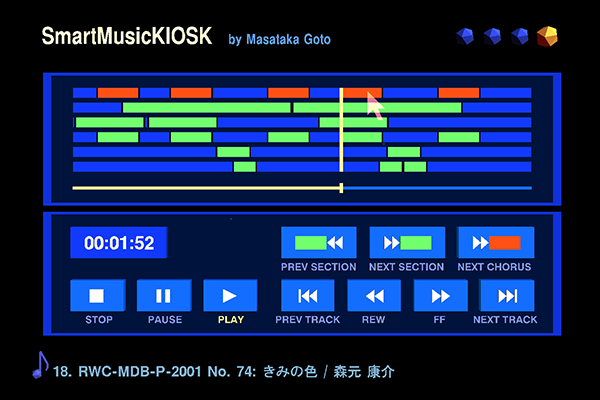

それがSmartMusicKIOSKで曲の中の繰り返し構造を可視化すると、普段あまり構造を意識せずに聴いている人でも、「ここはどうなってるんだろう?」みたいに意識が向くようになります。

例えば、この曲はまず、サビが5つあることがすぐわかります。さらに、サビの頭の歌詞に注目して聴いてみてください。

SmartMusicKIOSKを使うと曲の構造の理解が深まる。画像をクリックすると実際に曲を聴きながら解説している様子を視聴できます。

SmartMusicKIOSKを使うと曲の構造の理解が深まる。画像をクリックすると実際に曲を聴きながら解説している様子を視聴できます。

※上記の楽曲をSmartMusicKIOSKで聴いている様子のリンク

サビだけをクリックして順番に聴いていくと、最初のサビは「春色はきみの色~」と歌っていて、次のサビに飛ぶと「夏色はきみの色~」と歌っているんです。そうなると先の展開も予想できます。

――そうですね。季節を歌ってますよね。だから「秋」「冬」と続きそうです。

後藤実際にその後のサビを聴くと、「秋色は~」「冬色は~」となってます。ただ、そうなると5番目はいったい何なんだろう、と特別な関心を持って聴きたくなります。それで再生すると、「世界中にきみの色~」となっていて、ああ作詞家はそういう風にこの曲を創っているのか、と普段は歌詞にあまり注意を払っていない人であっても、曲の理解が深まるんです。

――確かに曲のストーリーみたいなものも見えてくる感じがしますね。

後藤こうやってSmartMusicKIOSKで音楽を聴くのはとても新鮮で楽しく、私は2002年にこれを開発できたとき、もう楽しくて自分で夢中になって何時間もいろいろな曲のサビ検出結果を見ながら遊んでしまいました。

――自分で作ったもので何時間も遊んじゃうっていいですね。やっぱり技術系の研究者は自分が欲しくて、でもまだこの世に無いものを初めて自身の手で作り出すっていうお仕事でしょうから、その喜びが感じられて。

後藤そうやってさまざまな曲で試しているうちに、技術で支援してもらいながら曲の再生位置をインタラクティブに変えて鑑賞してみると、さっきの歌詞の例みたいに、音楽を理解する力が増す、つまり、音楽の理解力が技術の力で拡張できる、ということを発見しました。沢山の楽曲の試し聴きに便利、みたいな出発点だったのが、音楽理解技術を用いた音楽鑑賞インタフェースを実現すると、他にも嬉しいことがいろいろとわかってくるわけです。

もともと音楽の鑑賞というのは受動的なだけではなく、聴きながら手拍子を打ったり声を出したりして能動的に鑑賞することを人は自然にやっていたわけです。

そこでさらに、音楽理解技術で世界初の音楽インタフェースを実現すると、もっと能動的に音楽とのインタラクションを楽しめるような新たな体験をいろいろと切り拓けることに気づき、「能動的音楽鑑賞インタフェース」という新概念を提案しました。

今紹介したのはその一例ですが、その後、さまざまな音楽理解技術と10種類以上の能動的音楽鑑賞インタフェースを実現していったんです。既存の曲を再生しながらドラム音やドラムパターンをその場で差し替えるような、より自分好みに加工するためのインタフェースも開発したりしました。沢山の楽曲に対してテキスト以外で検索するインタフェースもいろいろと開発してきています。

――こういうのは一般目線でもすごく面白いですけど、学会でも同様の反響ですか?

後藤ええ。こういう研究成果を国際会議や国内学会で発表すると、「これは素晴らしい!」とすごく高く評価してもらえて、「家で使わせて欲しい」っていっぱい言ってもらえて嬉しかったです。でも、やっぱりなかなかそのままでは使ってもらえないわけです。あくまで研究室内の技術デモだし、高性能なコンピュータで計算していたりしたので。

――確かに個人制作のプログラムでも環境によって動かないとかしょっちゅうですから、研究中の技術ってなるとなおさら大変そうですね。

後藤なので、こういう能動的音楽鑑賞の研究を10年くらいやっていく中で、社会にもっと直接的に技術貢献するにはどうすればいいかということを考えはじめました。それで今から10年くらい前に始めたのが、ウェブサービスの形で私たちの音楽理解技術を体験してもらえるようにしようという取り組みでした。

――なるほど、それが最初に見せてもらったような、一般の人でもすぐに触れるサービスの公開になるんですね。ではここからは最初にも少し見せてもらいましたが、後藤さんたちが公開したさまざまなウェブサービスに触りながらお話しを伺っていきたいと思います。

音楽の中身が可視化される音楽地図

――最初にやったウェブサービスはどんなものだったんですか?

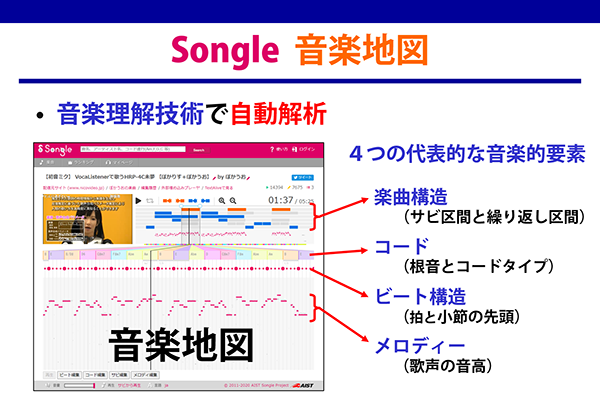

後藤やはりデジタル化された膨大にある楽曲の魅力を引き出すには、まずそれを自動解析しなければなりません。そこで「Songle (ソングル)」というサービスを研究開発しました。

Songleではさきほどご説明したSmartMusicKIOSKの楽曲構造(サビや繰り返し区間)に加えて、メロディ、ビート、コード進行という4つの代表的な音楽的要素を自動で解析できます。それらを可視化して楽曲の中身を聴く前にわかるようにしたものを、私は「音楽地図」と名付けました。

楽曲構造を可視化するウェブサービスSongle。画像をクリックするとSongleを体験できます。

楽曲構造を可視化するウェブサービスSongle。画像をクリックするとSongleを体験できます。

後藤音楽地図のサビをクリックすればそこから再生できるようにしたので、これでとうとうSmartMusicKIOSKを誰でも体験できるようになったんです!これによって私の長年の夢が1つ叶いました。

――これは解析結果だけを見るサイトではなくて、ここに音楽データを投げ込めばそれを解析してくれるんですか?

後藤はい、ニコニコ動画やYouTubeの音楽動画、ピアプロなどに対応していて、URLを入力すると10分くらいで自動解析してくれます。そうしてすでに自動解析されている250万曲以上の音楽地図も閲覧できます。ただ、Songleは音楽の配信はしていなくて、元のサイトからユーザーのウェブブラウザが直接再生する仕組みになっています。

もちろん自動解析なので、結果に誤りがある場合もありますが、それに気づいた人が自由に訂正できるような機能も付いています。

※Songleのサービスを体験してみる

音楽に連動した世界

後藤こうしてSongleで自動解析した音楽地図があると、それを使っていろいろな「音楽に連動した世界」を作れることに気づきました。

つまり楽曲のどのタイミングで何が起きるかということが分かっているので、音楽に合わせてロボットを踊らせたり、CGの映像を表示したりできるんです。

そのためのAPI (Songle Widget) を公開すると産業界も興味を持ってくれて、ロボット制御システムV-Sidoで有名なアスラテック株式会社とコラボをして、音楽に合わせてロボットを踊らせるシステム「V-Sido × Songle(ブシドー・ソングル)」を開発しました。

ロボットたちが音楽に同期して踊る「V-Sido × Songle(ブシドー・ソングル)」。画像をクリックすると実際のデモ映像を視聴できます。

ロボットたちが音楽に同期して踊る「V-Sido × Songle(ブシドー・ソングル)」。画像をクリックすると実際のデモ映像を視聴できます。

――これ可愛らしいですね。いろんなロボットがみんな音に合わせて同期して踊れるんですね。

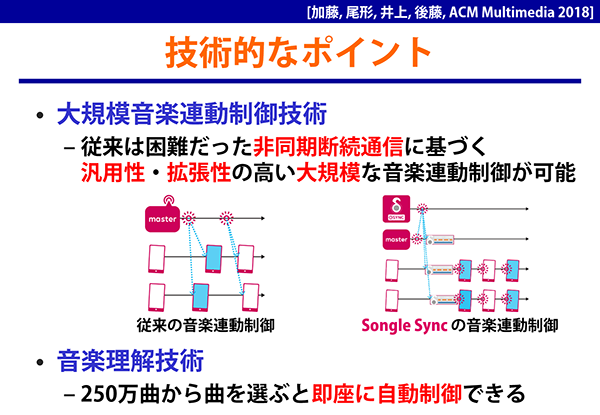

後藤こうやって音楽に連動してロボットや照明機器、CGをいろいろと制御しているうちに、さらに、大規模に数百台~数千台のスマホやパソコン、さまざまな機器を一斉に音楽に同期させることができれば、かつてない音楽体験が実現できるということを思いつきました。そこで、「Songle Sync(ソングルシンク)」という大規模音楽連動制御のためのプラットフォームを研究開発しました。

これを使うと、イベント会場の音楽の再生に同期して、そこにいる沢山の人たちのスマホの画面表示を一斉に変化させたり、スマホ以外にも照明機器の色を変えたりロボットを動かしたりすることができるんです。

――これ初音ミクのイベントでも使われたっていうので話題になってましたよね。

後藤そうなんです、2017年に幕張メッセで開催された初音ミク「マジカルミライ2017」というイベントで、DJステージを見ている600人以上の方々のスマホ画面に、Songle Syncで一斉に変わるCG映像演出を表示しました。スマホだとアプリをインストールしないと使えないような面倒なイメージがあるかと思うんですけど、Songle Syncはアプリが一切不要で、会場に来た人がパッとQRコードをスマホのカメラで読み取ってアクセスするだけで、即座に連動できるというのがポイントです。

さらに、2018年に初音ミクライブの「SNOW MIKU LIVE! 2018」でも実証実験を行って、数百人のスマホ画面に音楽に連動したCG映像が表示される演出をしました。ライブ中はみんなステージを見たいので、ライブが始まる前の待っている時間に、会場で流れるBGMに同期させてCG映像をスマホのウェブブラウザ上で生成して表示していました。

――ああいう時間は割と暇ですもんね。会場で待っている人たちのスマホの画面が音楽に同期して動いたら確かに楽しいですね。

後藤その後も、初音ミクの誕生日イベントで世界中からお祝いのメッセージを募集して、それを「マジカルミライ2018/2019」のイベント会場で音楽に同期させながらスマホに映すという演出もやりました。これは非常に好評で、2020年以降もオンラインで毎年実施しています。

※「Songle Sync」リンク こちらをクリックして「体験する」を押してみてください

――えー、これはすごい素敵ですね。

後藤実は過去の演出はこちらにアクセスして「演出スタイルの選択」から選べば、今からでも体験できます。例えば3台のスマホでアクセスすれば、それらが同期している様子を見ることができます。

――これがズレずに全てのデバイスで同期できるというのは、音楽に合わせているからということになるんですか?

後藤はい、ただ普通はこういう制御をしようと思うと、演出が変わるタイミングでその命令をサーバから送って、スマホがそれを受け取って表示するので、バラバラにズレて同期できないんです。YouTubeのライブ配信とかでも、ズレてしまいますよね。

Songle Syncでは、演出が変わるタイミングでは一切通信しないのがポイントです。実はSongleの音楽地図を活用して、それを各スマホに事前に配っておくんです。そして楽曲の再生開始時刻さえ決めておけば、各ビートがどのタイミングかはスマホ内で計算できます。あとはそのタイミングで表示を変えれば、ビートに同期しているように見えるわけです。これならばスマホが増えても、演出をピタッと合わせることができます。

Songle Syncが同期できる仕組み

Songle Syncが同期できる仕組み

――これはつまり曲を再生する最初のタイミングを合わせれば同期できるという感じなんですか?

後藤基本はそうなのですが、実際にはスマホやパソコンの時計は必ずしも正確でなく、途中参加も可能な仕組みにしているので、それを何百台、何千台と同期させるには最初に合わせるだけではダメで、どういう頻度で通信をして時刻合わせをするかとか、異なる環境の機器をどうやって同期させるかという部分でもかなり試行錯誤しました。

ただ重要なのは、Songle Syncの演出を体験する人たちはそうしたことを何も意識せずにQRコードを読み取るだけでよいし、実は演出を作るプログラマーですら通信のことは意識せず、1台のスマホ向けの演出をプログラミングするだけで大丈夫という点なんです。あとは、私たちのSongle Syncが面倒くさい通信の仕組みを裏側ですべて実行して、沢山のスマホが連動してくれます。

産業界の方々がプログラミングをする形でSongle SyncのAPIが活用された事例として、2019年の花火大会で、花火の打ち上げに連動した音楽を来場者のスマホで流しながら、曲名やCGを表示する演出に利用されました。

花火大会の演出でも利用されたSongle Sync。画像をクリックすると実際の花火大会の様子が再生されます。

花火大会の演出でも利用されたSongle Sync。画像をクリックすると実際の花火大会の様子が再生されます。

――ああ、ウチの近所の花火大会も会場にスピーカーを置いて音楽と連動した打ち上げってやってましたけど、やっぱ距離によって聞こえなくなったり音と光だとズレていったりってあったので、それをスマホから聞いて楽しめたらすごくいいですね。

後藤さらに、街と音楽が連動する演出も可能で、2020年に札幌市の中央部で開催された「SYNCHRONICITY 2020」というイベントでも利用されました。音楽に合わせてビルや街路樹が光っているんですが、公共の場所なので音楽は実際には鳴っていなくて静かなんです。

でも、通りがかりの人がこのイベントのQRコードをスキャンすると、スマホのヘッドホンからSongle Syncの仕組みで音楽が流れてきて、アクセスした人だけが音楽と連動した演出として楽しめる仕組みになっています。

「SYNCHRONICITY 2020」画像をクリックするとイベントの様子を視聴できます。

「SYNCHRONICITY 2020」画像をクリックするとイベントの様子を視聴できます。

――こうしてみると、圧倒されてしまうほど色々なところで活躍していて、音楽地図を生み出す音楽理解技術から新しい体験が次々と作られていますね。

後藤ありがとうございます。ここまでは音楽に連動した新たな音楽体験という鑑賞側の話でしたが、他にも、音楽に連動した映像コンテンツの創作支援にも取り組みました。

――ああ、そこで最初に紹介した「TextAlive」の研究に繋がっていくんですね。

後藤そうです。さきほどはどうして音楽に合わせて自動で歌詞の演出が表示できるのかという技術的な説明は飛ばしていましたが、歌詞の各文字の発声タイミングを自動推定する音楽理解技術を開発して利用しています。さらに、「TextAlive」もSongleの音楽地図を利用していて、音楽のビートやサビで演出が自動で変わるようになっています。

「TextAlive」が自動でリリックビデオを生成できる仕組み

「TextAlive」が自動でリリックビデオを生成できる仕組み

――なるほど、さっき見せてもらったときは、すごいけど何でそんな事ができるのかわかりませんでしたが、こうして説明を聞くと納得ですね。

ただ、これってその歌詞をタイミング良く表示するという部分の技術もすごいですけど、普通に見ていてカッコいいっていうのがすごいですよね。表示される歌詞のデザインが非常に優れていて、この部分のカッコよさっていうのはどうやって作っているんだろうっていうのも気になるんですが。

後藤こうしたウェブサービスは私1人の力ではなく、チームで作っているものですが、それはTextAliveの研究開発を主導している加藤淳が外部の協力も得ながら頑張っている部分です。彼はTextAliveのサーバもクライアントも実装しただけでなく、デザインセンスにも優れています。

ここでちょっと注意していただきたいんですが、さっきの「SmartMusicKIOSK」は私が1人でサビ検出技術を研究開発してインタフェースも自分でOpenGLで実装した研究ですが、それ以外のさまざまなウェブサービスや技術は、産総研のメディアインタラクション研究グループの非常に優秀な研究者たち、エンジニアたちと一緒にチームワークで作ったものなんです。

なので私が代表して紹介はしていますが、私一人だけの研究成果だと勘違いしないようにしていただけたらと思います。

――そうですね。確かに一般の人たちは研究のチームって言われてもあまりピンと来ないところがあるかもしれないですが、映画なんかと同じですよね。大勢の人たちが集まって作られている。

後藤映画ほど人数は多くなくて少人数チームですが、これだけ大規模で複雑な技術になると一人で完成させるのは難しいです。TextAliveもウェブサービスとしての実装や演出の自動生成とかは加藤が担当していますが、音楽理解技術の研究には加藤は関わっていなくて、例えば歌詞の発声タイミング推定は、中野倫靖が開発した技術です。

なので、私たちのウェブサービスを体験しながら、その辺りも意識していただけたら嬉しいです。そうした多才なプロの研究者がチームを組んで研究できるところが産総研の強みでもありますから。

自分の好きな音楽に出会う技術

――さきほど後藤さんは音楽がデジタル化されて膨大な楽曲にアクセスできるようになった一方で、好みの楽曲に出会うことが難しいという問題を話されていましたよね。

後藤はい、既に膨大な楽曲がある上に、新しい楽曲も日々生まれ続けているので、残りの人生すべてを使って音楽を聴き続けたとしても、この世のすべての音楽を自分でチェックするというのは不可能なわけです。なので、音楽理解技術の力を借りながら、自分好みの音楽に出会える技術が重要になります。

――確かにそれはどんなコンテンツにもありうる問題ですよね。だから最近はこれを見た人はこんなのも見てますとか、あなたのオススメみたいな提案をするシステムってどこにでも搭載されてますね。

後藤そういうシステムの多くは、協調フィルタリングという技術に基づいています。ただ、その技術は問題があって、人気のある作品ばかりがオススメされやすいんです。つまりまだ誰も聴いていない作品、新人の作品は、それを好きになりそうな人がいたとしても表示されないんです。

これは視聴者にとって好みの楽曲に出会えず、人気の楽曲にさらに人気が集中してしまう問題を生みます。そうするとクリエイターにとっても、せっかく創った曲が、それを気に入ってくれるはずの視聴者に気づいてもらえずに、どんどん良い曲が埋もれていってしまう問題を生むんです。

つまりこれは音楽を聴く側にとっても創る側にとっても、さらには多様で豊かな音楽文化の未来にとっても解決すべき本質的な問題で、しかも、技術の力なしには解決不可能な問題なわけです。

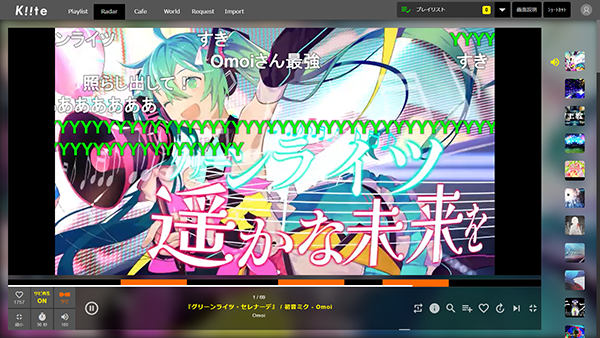

そこで研究開発したのが、音楽発掘のための「Kiite(キイテ)」というサービスです。

※Kiite の公式サイト

好みの楽曲を発掘するサービス「Kiite」

好みの楽曲を発掘するサービス「Kiite」

これは裏側に音楽理解技術や音楽推薦技術が入っていて、ニコニコ動画にある歌声合成楽曲(ボカロ楽曲)46万曲の中から好みの楽曲を効率よく探索できるというサービスです。

試し聴きするのにも便利なサービスで、Songleで解析したサビだけを次々と聴いていける機能が付いています。ここでも私が約20年前に作ったSmartMusicKIOSKのサビ検出技術が役立っているのが嬉しいです。

――ほんとにどこまでも使える技術ですごいですね。

後藤この画面で下側のオレンジ色になっている区間がサビですが、沢山の曲のサビの出だしを次々と聴いていって、気に入った曲があれば「いいね」(お気に入りボタン)を押して、後で楽曲全体をゆっくり聴き直すということができます。

本当は最初から最後まで聴いてもらえた方がクリエイターは嬉しいのですが、まったく聴いてもらえないぐらいなら、曲のサビだけでもちょっと聴いてもらって、発掘してもらえる方がよい、というのがこの機能のコンセプトです。

「Kiite」のプレーヤー画面。画像をクリックすると「Kiite」のデモ解説動画が視聴できます。

「Kiite」のプレーヤー画面。画像をクリックすると「Kiite」のデモ解説動画が視聴できます。

それでも46万曲を全部聴くということはできないですから、自分にあった聴きたい曲を絞り込めるレーダー機能というものも用意しています。

これは音楽の印象を自動解析していて、激しめの曲とか、のんびりした曲というのがレーダー画面の違うエリアに配置されています。例えば、のんびりした曲というエリアをクリックすると、その候補になる楽曲がリストアップされて聴くことができます。

「Kiite」の音楽の印象で曲を探すレーダー機能。画像をクリックするとデモ解説が視聴できます。

「Kiite」の音楽の印象で曲を探すレーダー機能。画像をクリックするとデモ解説が視聴できます。

――激しめの曲とかそういう印象はビートなんかを元に推定しているんですか?

後藤いえ、違います。これは事前に人手でラベリングした音楽の印象を大量に機械学習させて、その学習の結果から音楽の印象というものをシステムが推定できるようになっているんです。ここまでに説明してきたのとはまったく別の音楽理解技術を使っています。なのでこのサービスは印象から曲を探せるっていうのが特長の1つになっています。

他にも、音楽推薦機能、いわゆるリコメンド機能が付いているのも大きな特長で、ユーザーが過去に「いいね」をした曲とかに基づいて、その人の好きそうな楽曲がリストアップされます。これはすごく便利で、そこにさらにサムアップとかでフィードバックをしていくと、どんどんその人の好みに合わせた推薦エンジンが育っていきます。

どうしても今までは、知っている曲名とかアーティスト名を入力して探すとか、ランキングに頼って曲を聴くという場合が多いので、それとはまったく異なる曲との出会い方を実現したかったんです。

――では、この推薦する技術っていうのは、よくサブスクとか通販で使われている協調フィルタリングとは全然違うんですね。

後藤はい、違います。それだとさきほどもお話した通り、いろんな人が聴いて人気が出た曲だけが推薦されやすくなってしまいます。でもKiiteは人気があるから推薦されるだけではなくて、まだ誰も聴いていないけど、その人が好きな曲調に近い楽曲を音楽理解技術で解析して推薦できるのが特長です。音楽の中身や、自分や他の人がどう聴いているか、同じクリエイターの作品か、とかに基づいて総合的に推薦できるんです。

――じゃあ今日誰かが投稿したばかりでまだ誰も聴いていない曲だったとしても、その人が好きそうなら推薦されるということなんですね。

後藤そうです。なので、これはクリエイター側にも嬉しい機能になっています。

ただ、いくら優れた仕組みを作っても、コンピュータが推薦してくるものだけを聴くという方法では、人間の自由意志を奪いかねません。なのでこのKiiteでは、推薦は音楽と出会う一手段にすぎなくて、他にもさまざまなやり方で自分の知らない音楽と出会う仕組みを取り入れています。

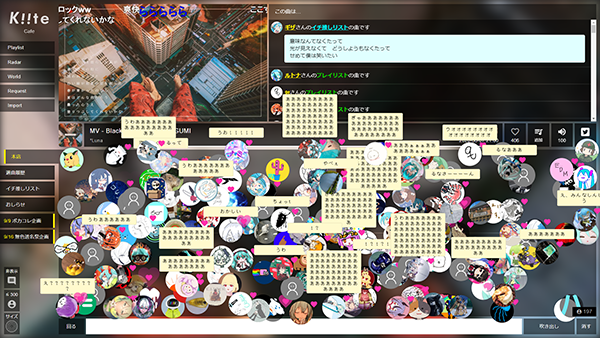

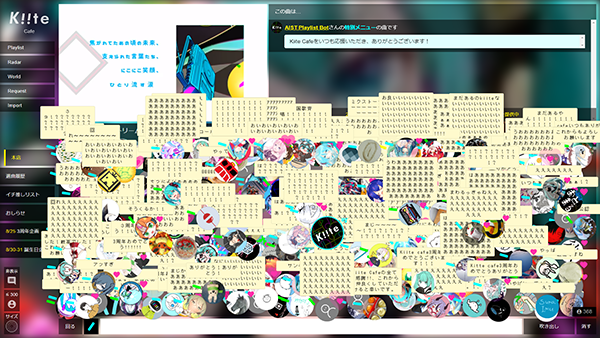

その1つが2020年5月に公開した「Kiite Cafe(キイテカフェ)」というみんなで一緒に音楽が聴けるサービスです。

「Kiite Cafe」の画面。画像をクリックするとデモ解説を視聴できます。

「Kiite Cafe」の画面。画像をクリックするとデモ解説を視聴できます。

この丸いアイコンの1つ1つがKiiteのユーザーで、ここにいる人たちがみんなで一緒に同じ音楽を同じ瞬間に聴いています。そしてここで流れる曲は、集まっている人たちの好きな曲がランダムに再生されるんです。特に、みんなに聴いてもらいたい曲は各自が「イチ推しリスト」としてセットできて、そこから優先的に選ばれます。画面の右上を見ると、誰のイチ推しリストから流れたのかがわかります。

そして、それを一緒に聴いている人たちが、吹き出しのコメントで感想や喜びの声を書き込んで会話ができる機能も付いています。さらには、その曲が気に入って「いいね(ハートマーク)」を押すと、自分のアイコンの右上にハートのアニメーションが出るんです。

ここで自分の好きな曲が流れたときに、他の人たちが気に入ってハートが表示されると、ものすごく嬉しくて感激するんです。これはほんとに衝撃的で、自分で作った曲ではないのに、自分の好きな曲をみんなが気に入って反応してくれる感動は、是非体験してもらいたいです。

――リアルタイムにみんなで共有して聴いているから、その場で生のリアクションがもらえるっていう部分が大きいんですね。

後藤まさにそうなんです。自分が好きな曲を目の前の人が聴いて、その人が喜んで私も好きって反応してくれる。その輪が広がっていくっていうのが、多くの人の感動を呼んで、このサービスのファンになる人が増えていきました。

Kiite Cafeはもともと、コロナウイルスによってみんなで集まって音楽を聴くということが難しくなってしまった2020年に、私たちも何か貢献できないかと考えて作ったサービスなのですが、みんなで好きな音楽をオススメし合って一緒に聴くという体験が提供できただけでなく、「自分の好きな曲を他の人たちが気に入るまさにその瞬間」を見ることができるという新たな価値を生むことができて、さらには、普通の音楽推薦とは異なる方法で音楽との出会いの場を作れたという点でも、非常に魅力的なサービスだと思っています。

※Kiite Cafeを使ってみる

――確かにこのごちゃごちゃっとアイコンが表示される雑多な感じも、クラブハウスにいるみたいで盛り上がりを感じて楽しいですね。

後藤ですよね。そうしたデザインも含めて、同じチームの石田啓介が中心的にアイデアを出して実装をしているのですが、本当に素晴らしいです。Kiiteの研究開発チームで毎週のように打ち合わせながら、アイデアを出し合って、さらに新しい機能も次々と追加していきました。

例えば、Kiite Cafeを公開してしばらくすると、普通のカフェみたいに、これを使って貸切コラボイベントとかもできないか、ということになりました。そこで、コラボ時間帯だけは選曲をランダムにしないで、プレイリストを決めてライブみたいに盛り上がれる機能を追加して2020年8月から開催しました。

さらに2021年3月には、コラボイベント中だけペンライトを振れる新機能を付けました。しかも、せっかく私たちがやるからには音楽理解技術を使わない手はない、ということで、さきほどのSongleの音楽地図を利用して、曲ごとのテンポに合わせて振る速さが変わるようにしたんです。初めてお披露目したとき、ペンライトを振る速さが変わる!とユーザーがものすごく驚いてくれて、嬉しかったです。

2023年8月には、3周年記念でファンに対する感謝を込めて、さらにペンライトの色も変えられる新機能を付けました。

色とりどりのペンライトを振って音楽を楽しむユーザーたち。画像をクリックするとデモ解説を視聴できます。

色とりどりのペンライトを振って音楽を楽しむユーザーたち。画像をクリックするとデモ解説を視聴できます。

――研究で公開されている技術がこれだけ大勢を感動させているというのはすごいですね。

後藤ユーザーの皆さまには私たちも本当に感謝していて、私たちの想像を超えてすごい応援をしてくれているんです。

以前もKiite Cafeファンの皆さまが自発的に「Kiite Cafe宣伝祭」というのをやってくださって、テキストやイラスト、動画のようなさまざまな形で広告とかCMを作って、「よいサービスだからみんな使って」ってSNSで宣伝してくれたんです。事前にはもちろん知らなかったので、本当に驚いて、開発チーム一同、喜んでいました。

他にも驚いたことはいろいろあって、「マジカルミライ2023」のイベント会場にはいつものようにいっぱい花(フラワースタンド)が贈られて並んでいたんですが、そこになんと、Kiite Cafeファンがお金を出しあって「Kiite Cafeユーザー一同」というフラワースタンドを出していたんです。

あまりに嬉しくて、私も記念写真を撮ってしまいました。

――これすごい素敵な話ですね。研究の話を伺っててこんなエモい話を聞くとは思いませんでした。

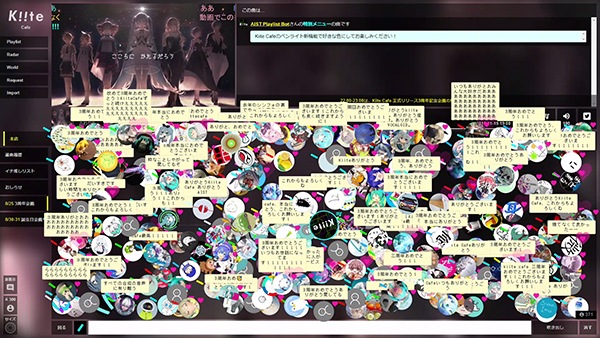

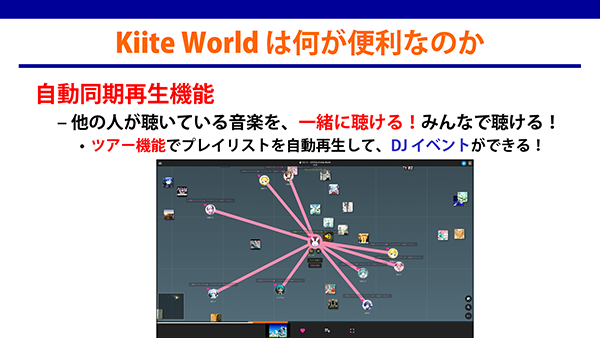

後藤今ずっとKiite Cafeの話をしてきましたが、2023年にはさらに、「Kiite World(キイテワールド)」っていう新しいサービスを公開しています。

これはKiiteのユーザーが好みの100曲のプレイリスト(100選)を作ったら、それを自分の「音楽世界」として公開して、お互いに聴くことができるというコンセプトのサービスです。

自分の「音楽世界」を公開してお互いに聴き合える「Kiite World」。画像をクリックするとデモ解説を視聴できます。

自分の「音楽世界」を公開してお互いに聴き合える「Kiite World」。画像をクリックするとデモ解説を視聴できます。

左下の雲みたいな白い点1つ1つが楽曲で、ランダムに並んでるわけでなくて、さきほどの音楽推薦技術によって、似た好みを持つ人たちが好きそうな楽曲が近くになるように計算されて配置されているんです。

――少し大きい白い丸がいくつもあるのはなんですか?

後藤これは今アクセスしているユーザーを表示しています。お互いの位置や何を聴いているのかもわかる仕組みです。

さらに、一緒に同期して同じ曲を聴く機能も付いています。この機能を使うと、ピンクの線で結ばれて、一緒に聴いているんだな、ってことがわかります。音楽をイヤホンで聴いてるときに片方貸してあげて一緒に聴くことがあるじゃないですか。そんな感じで、他の人が聴いている音楽に興味があったら、誰でも一緒に聴けるんです。

ユーザーが同期して一緒に曲を聴くこともできる。

ユーザーが同期して一緒に曲を聴くこともできる。

しかも、日時を決めて呼びかければ、みんなで一緒に音楽を聴くイベントを誰でも気軽に開催できるんです。実は2023年12月にはアドベントカレンダー企画ということで、Kiite Worldのユーザーの皆さまがほぼ毎日そういうイベントを開催してくれていて驚きました。それ以前にもさまざまなイベントが開催されていましたし、1月以降もいろいろなコンセプトで、沢山のKiite Worldイベントを呼びかけてくれています。

――ほんと広がり方がすごいですね。

後藤多くの皆さまにこうして興味を持っていただけるのは本当にありがたくて嬉しいです。

――これはもうほんとサービスとして成立しているように見えますが、やはり研究の一環なんですよね?

後藤そうです。私たちはウェブサービスに関連した論文もいろいろと書いて学会で発表してきていますが、例えばKiite Cafeでは論文発表よりも先にサービスを公開して、ユーザーの皆さまが楽しんでいる様子なども含めて後から論文にしています。

――こうした研究は学術的にはどのような評価を受けているんですか?

後藤受賞や国際論文採択も含めて高く評価していただいていますが、アイデアや技術の新規性だけでなく、実際にサービスを公開してどう使われたかも分析している点が、さらに高い評価につながっているかと思っています。

――なるほど。さきほどからユーザーへの感謝をずっと述べられていますけど、もう後藤さんたちの研究というのは利用するユーザーと一体になって進んでいく研究なんですね。

後藤とてもありがたく思っています。今回のこの記事もそのきっかけになればと思うんですが、私たちの研究に興味を持ってくれて、ウェブサービスを利用してもらえるのは本当に嬉しいです。また、これをきっかけに音楽情報処理を研究すること自体に興味を持って、未来に一緒に研究分野を盛り上げてくれる人たちが増えてくれると、さらに嬉しいなと感じています。

研究の入り口はどこにある?

――今、新しい研究者がこの世界に入ってきてくれることも嬉しいとおっしゃられていましたが、研究の世界って敷居が高いと感じる人も多いでしょうし、学生さんなんかは、研究者の入り口ってどうなっているんだろうって聞いてみたいと思うんですね。

なので後藤さんの音楽情報処理研究はどのように始まったのか聞かせていただけますか。

後藤私は1992年に大学4年生で卒論に取り組んだのですが、指導教授の村岡洋一先生は「研究テーマを学生が自分で見つけること」を重視していて、好きなテーマを提案できる機会が与えられました。そのとき、自分が高校生の頃に音楽を流すとそれを楽譜で出力してくれるシステムが欲しかったことを思い出して提案したのが始まりです。

ただ、研究室の先輩は誰もやっていない分野なので、研究テーマが本当に世界初なのか、求めるユーザーはいるのかを自分で調べて考えるように言われたんです。

――研究テーマを自分で探させるということですよね。もうすでに誰かがやっていて分かっていることなら研究する意味はないし、欲しい人がいない技術を作っても仕方ない。それを学部生の段階でちゃんとやらせる先生だったんですね。

後藤当時はウェブサイトも検索サービスもない時代でしたから、大学の図書館に1週間くらいこもってひたすら文献調査をしました。それで、当時は一つの楽器だけが鳴っているときにそれを解析する技術はあっても、いろいろな音が同時に鳴っているドラムの演奏音を解析して、ドラムの楽譜を出力する技術を実現できれば世界初だし便利なことに気づきました。それを説明して、卒論の研究テーマにさせてもらいました。

実際に卒論の研究成果は世界初で、その後、電子情報通信学会論文誌に採択されました。

――学部のころの研究だと今とは全然違うことをやっていたという方も多いと思いますけど、後藤さんはもうそのときから方向が一貫してたんですね。今日伺ったいろんな研究に繋がっている印象がありますね。

後藤そして1993年に大学院の修士1年生になると、村岡先生から、せっかく並列処理の研究室で最先端の並列計算機AP1000が使えるので、もっと大規模な計算で何か新しい研究テーマを考えたら?というアドバイスをもらいました。

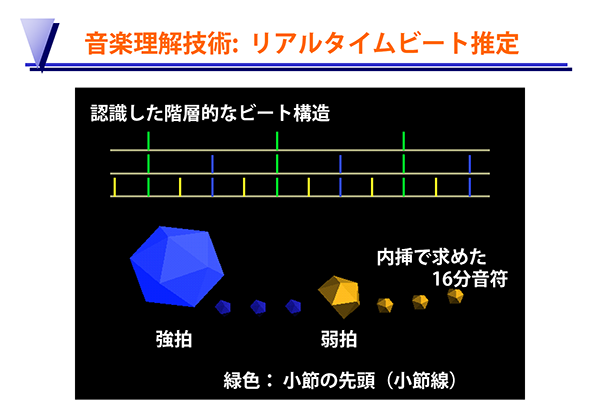

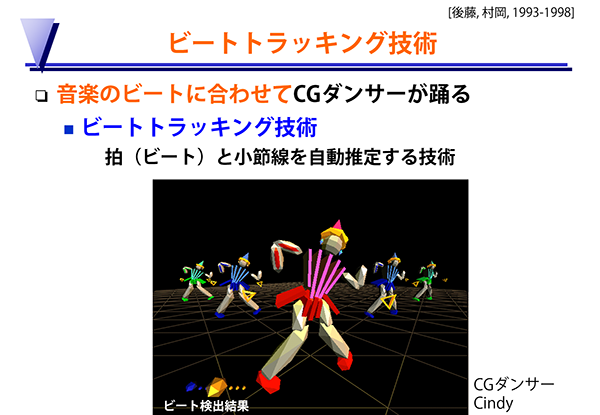

そこで今度は、音楽のビートを見つけるビートトラッキングという研究を提案しました。卒論のようなドラム音だけが鳴っている入力ではなくて、普段耳にするポピュラー音楽みたいに沢山の音が鳴っている入力を解析する技術を実現したくて考えたテーマです。

より難易度は高かったのですが、音楽のビートって人間が聴けばすぐに分かるじゃないですか。なので、ビートを見つけることならできるんじゃないかと考えたんです。当時は高速フーリエ変換ですら計算量が多くてリアルタイムに計算するのは難しい時代で、さらにさまざまな信号処理や推定処理も駆使したので、並列計算機の64個のCPUを使ってビートの解析ができて楽しかったです。

後藤さんが学生時代に発表したシステム。画像をクリックすると実際に動作している様子が見られます。

後藤さんが学生時代に発表したシステム。画像をクリックすると実際に動作している様子が見られます。

これが学生時代に実現したシステムのデモビデオですが、音楽に合わせてイチ、ニ、サン、シと、4分音符のビートを自動検出できています。さらに博士課程では、小節の先頭がどこかということも検出できるように拡張しました。

沢山の音が混ざっているポピュラー音楽の音響信号に対して、こういった情報が取り出せるというのは世界初でした。

――さきほどのSongleでも、ビート構造を取り出す技術が入っていましたけど、こんな初期の研究からビートを見つけるという事に目を付けていたんですね。

後藤そうですね。今Songleで使っているビート推定は深層学習を利用した全然別の技術ですが、その後の音楽理解技術に発展する研究として、学生時代にビートに着目できたというのはとても幸運でした。あとからそれが研究分野の重要標準問題になったとき、先駆的な研究として沢山引用してもらえましたし。

こうして音楽からビートが取り出せるようになると、さきほども紹介したみたいに、いろんなことができるようになるわけです。ただ1990年代には、そもそもそういう技術の存在は知られていないし、その技術が何の役立つのかをわかってもらえないことがありました。なので、このビートトラッキングという技術がどういう風に役立つのかを、自分自身で応用例も実装して示そうと考えたんです。信号処理も楽しかったけど、CGのOpenGLプログラミングも大好きだったので、ちょうど一石二鳥でした。

ビートトラッキング技術を用いてCGダンサーを踊らせたデモビデオ。画像をクリックすると動いているデモビデオが視聴できます。

ビートトラッキング技術を用いてCGダンサーを踊らせたデモビデオ。画像をクリックすると動いているデモビデオが視聴できます。

そうして、音楽のビートに合わせて踊るCGダンサーを表示するシステムを作りました。1994年から開発して、その後もブラッシュアップしてこれは1998年に録画したデモビデオです。CGダンサーの頭上に最初「?」が浮かんでいますが、ビートと小節の先頭が見つかると自動で踊り出します。

今はチープなCGに見えますが、当時はこれが最先端の映像だったし、人手で作り込まなくても音楽のビートを解析すれば自動で作れるって示したことで、なるほどこれはすごいってわかってもらえて、テレビ番組でも取り上げられました。

――確かにCGのキャラクターが踊ってるって90年代だとかなりすごいことですよね。

後藤この経験で、音楽理解技術の基礎研究だけやっていても、社会でどう役立つかはなかなか理解してもらえないことがあるので、技術の利用方法を可視化して示すことが重要だとわかりました。それによってより多くの人たちに面白いねと評価してもらえるんです。

あと、実はビートに合わせて照明制御できることもこのCGダンサーのビデオの中で示していて、当時は実世界の照明の制御はできなかったからCGの中で見せていたんです。それから約20年後に、さきほどのSongle WidgetやSongle Syncで実際に物理的な照明機器をビートに合わせて制御できたのは、感慨深かったです。

――それはすごいですね。じゃあほんと昔から考えていた事が次々実現しているのが、さきほどお聞かせいただいた色々なサービスなんですね。

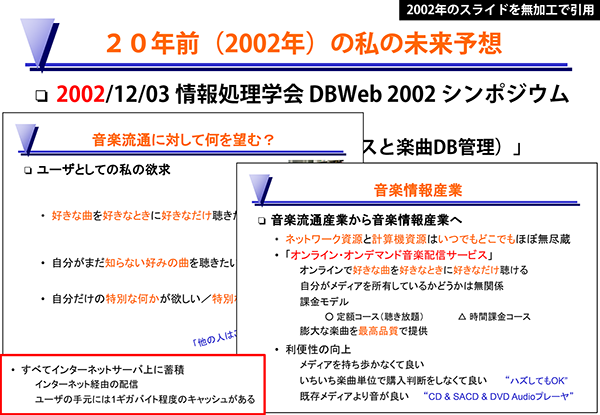

そのあと2000年代に入ってMP3プレーヤーなどが出てきてデータで音楽を持ち歩く時代になりますけど、その頃にはもう後藤さんは未来ではみんな音楽データを持ち歩かずにネットで音楽が聴き放題の世界になるって予想されていたそうですね。

後藤そうですね。2002年のシンポジウム発表でそのことを主張して、2004~2005年には定額制音楽配信サービスが将来普及することを前提にした研究(Musicream)を国際会議や国内学会で発表していました。当時は、未来ではすべてはインターネット経由の配信になって、ユーザーの手元には1 GBの超巨大なキャッシュがあるだけになる、って主張しても、現実離れしていてみんな信じにくかったんですが、今はスマホでも64 GB以上のストレージが普通だから、もうそんな容量は簡単に飛び越えてしまいましたね(笑)。

2002年のシンポジウムで後藤さんが未来予想について語ったスライド。画像をクリックするとこのスライドを紹介しているプレゼン動画が視聴できます。

2002年のシンポジウムで後藤さんが未来予想について語ったスライド。画像をクリックするとこのスライドを紹介しているプレゼン動画が視聴できます。

※2002年のシンポジウム発表のスライド紹介

初音ミクとの出会い「産総研P誕生秘話」

――今回記事の一番最初に「産総研P」とか「南極点のピアピア動画」の話題に触れましたが、後藤さんは初音ミクの研究をしている人って印象も強いと思うんですね。

未来を視るという意味では、後藤さんはすごい早い段階で初音ミクとかニコニコ動画を研究に取り込んでいたのも特徴的だと思います。ここに目を向けたきっかけというのはなんだったんですか?

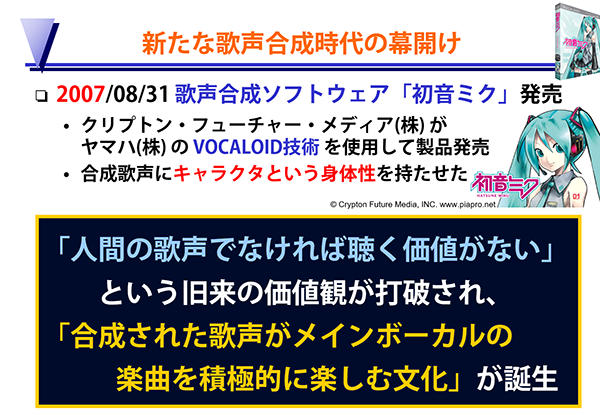

後藤歌声合成技術の研究発表は1990年代からいろいろと見ていて、初音ミク以前にもいろいろな製品が発売されていました。中学生のとき、店頭のPC-6601に歌わせたこともあります。だから、もちろん技術的には知っていたんですが、初音ミクが当時登場した衝撃というのは、この技術が一気に普及して人々の価値観を変えたことと、ユーザーのクリエイティビティを引き出して連鎖させたところにあると思っています。

――確かに今でこそ初音ミクのお姉さんとお兄さんという形で人気になっていますが、MEIKOとKAITOって出てきたときは私の周りでDTM(パソコンで音楽を編集すること)を趣味にしている人でも、これで歌声と呼ぶのは厳しいよねという感じで、あまり注目されていなかったですね。

なので初音ミクの登場で、機械で合成された歌声にみんなが魅了されたっていうのはかなり驚きでしたね。

後藤まさか合成された歌声がメインボーカルの楽曲をみんなが楽しむようになるとは、予想できませんでした。それまでの常識として、人間の歌声でなければ聴く価値がないという暗黙の価値観があったので。その古い価値観が打破されました。

初音ミクの発売は2007年8月31日なんですが、私が幸運だったのはこのときヤマハのVOCALOID開発者である剣持秀紀さんと、ベルギーのアントワープの国際会議でお会いしていたことでした。

初音ミクも会場で展示されていて、こんな製品が出るんですよって見せていただいて、日本のほとんどの人が知るよりもいち早く国際会議で開発者本人からデモを交えて紹介してもらえたんです。初音ミクの発売もこの会議中でした。

それで、ちょうど目の前の剣持さんに日本から国際電話があって、電話を切った瞬間に「後藤さん、初音ミクが量販店の店頭で売り切れましたよ!」と教えてくれたんです。私もそこでなにかすごいことが起きているって認識できたんです。

2007年8月31日に発売した歌声合成ソフト「初音ミク」のヒットは世の中の価値観が変化した瞬間だった

2007年8月31日に発売した歌声合成ソフト「初音ミク」のヒットは世の中の価値観が変化した瞬間だった

――初音ミクは発売直後からすごい人気でずっと売り切れ騒動みたいなのが続いていましたよね。欲しくても全然手に入らないという人が続出して。

後藤そこからはもうニコニコ動画に毎日のように新しい作品が投稿されていくのをチェックして、いかにすごいことが起きているのかというのを目の当たりにしながら、いろいろと考察していました。

――後藤さんは、ここまでの紹介の中でもクリエイター側の創作支援に関する技術に触れられていましたよね。こうした1つのソフトの発売で大勢の人々の創作意欲が爆発して次々に新しいコンテンツが生み出されていくというのは、もうそれだけでかなり驚くべき現象だったんですか?

後藤そうですね。N次創作と呼ばれる創作の連鎖が次々と起きて、楽曲が作られるだけではなくて、PVを別の人が付けたり、「歌ってみた」「踊ってみた」のような派生作品がどんどん生まれていきました。

それと、初音ミクが発売されて数カ月の間に、歌声合成の声の高さや大きさのパラメータを巧みに調整して、人間らしく自然に聞こえる歌声を作り出すことに力を入れた作品が投稿されていたんです。

――ネットでは調教と呼ばれていた自然な歌声に近づけるための調整ですね。これが上手いと「神調教!」と盛り上がっていましたね。

後藤それを見ていて、私たちの音楽理解技術を応用すればもっと自然に合成できるということに気づいて、当時は若手研究者だった中野倫靖と一緒に作ったのが「VocaListener(ぼかりす)」です。これは人間のお手本の歌い方を解析してVOCALOIDの歌声合成パラメータを作り出すことで、自然な歌声を合成できる技術です。人間が歌うだけでそれを真似て調整できたので、個性的なビブラートや、演歌のような複雑な歌い方も合成できました。

――これほんと自然な歌声に聞こえてすごいですよね。この「ぼかりす」のデモを公開したことが「産総研P」という呼び名が誕生したきっかけですね。ただ何よりびっくりなのは、これが初音ミクが発売されて半年とかそれくらいですぐに出てきたことです。

私も当時これを見ていて、みんなが初音ミクをもっと自然に歌わせられないかって調教に苦労していたときに、いきなりポンと人間が歌えば自動で調整できますって技術デモが出てきて、なんじゃこりゃ、もうこんなのがあるのかって驚いたのをよく覚えています。

後藤これがいち早く実現できたのは、技術の蓄積があったからです。1998年に博士の学位を取得して研究所に就職してから、私は音声認識とか音声インタフェースに関する研究も同時並行でやっていたんです。

――え、こんだけ成果があるのに、まだ他にも色々と裏で研究なさっているんですね。

後藤一方で、音楽理解技術としては、沢山の音が混ざっている音楽の中から歌声を抜き出す世界初の技術も1998~2000年ごろに私は実現していて、その歌声を使うと、いろいろな新しい研究テーマを思いつける状態でした。それで2000年代には、次のフロンティアは歌声関連の技術だと考えて、かなり力を入れていたんです。

というのも歌声って、音楽と音声の両方の側面があってどちらの技術も必要だから、どちらの研究分野からも難しくて手が出しづらい状況だったんです。

音楽情報処理の立場から見ると、楽器音と違って、声のような音素が次々と変わっていく音響信号って、難し過ぎてなかなか上手く解析できない。一方、音声認識の立場から見ると、話し声と違って、歌声って母音が伸びたり高さが大きく変動したりするから、一番難しい種類の声で上手く認識できなかったんです。

なので歌声の研究って、まだ取り組まれていない研究テーマが沢山あることに気づいたんです。そこで私たちの音楽理解技術と音声認識技術の蓄積で、いろいろな研究に取り組んで発表していました。私はそれを2008年に振り返って、「歌声情報処理」と名付けています。

さきほどお話した剣持さんとお会いした国際会議でも、そうした歌声関連の研究成果を発表していました。

――じゃあ、「ぼかりす」はその両輪で研究を進めた成果があったからこそ、あんなにすぐ発表できたということなんですね。

後藤そうですね。技術の蓄積がなければ不可能でした。

ぼかりすが人間の歌声をお手本にVOCALOIDの歌声合成パラメータを自動調整する流れ

ぼかりすが人間の歌声をお手本にVOCALOIDの歌声合成パラメータを自動調整する流れ

そのため、私たちの「ぼかりす」のデモには、VOCALOIDを開発したヤマハ自身も「こんなことができるのか!?」と驚いて。そこで製品化しましょうとヤマハからご提案をいただいて、実際に発売されることになりました。

――過去の蓄積が活きているというか、基礎研究がいかに重要かってお話しですね。

後藤その通りで、技術と知見が蓄積しているからこそ、普通は長期間かかる開発も、短期間でできることはよくあります。

技術研究に重要な未来予測の考え方

――こうしてお話しを聞いていると未来予測が研究者にとっていかに重要かってことを感じます。技術研究で成果を出している人たちは非常に未来を予測するのが上手いという印象をいつも受けますが、後藤さんはどうやって先を予想しているんですか? なにか秘訣がありますか?

後藤技術から発想する場合も多いですが、私はSF小説を読んだり、自分の研究とは関係なくても未来について考えたり人と話したりするのが好きなんです。そういうことをやっていると、「ああこんな未来になるなら、自分の技術がそこに組み合わさってこういう事ができるんじゃないか」って浮かぶことがあります。

――そう聞くと、SF好きの人たちが趣味でやっていることと大きくは変わらない感じがしますね。SF作品を元に自分の面白いと感じる未来を想像して、それを核にその世界で起きそうな問題をテーマにするという。

後藤未来予想は研究者それぞれで違うでしょうし、そうして予想した未来の誰も解いたことのない問題を解けば、必ず世界初の研究になる。なにか先にやっておけば、後でそれが必要になったときに先駆者として自分たちの名が上がるかもしれない。それは研究者として非常に嬉しいことですし、それに魅力を感じて、より多くの人たちが研究者になってくれると嬉しいです。

これからの未来について

――では最後に後藤さんが考えるこれからの未来について伺って今回の記事を締めようと思います。これまでも未来について色々予想しながら研究を進められてきた後藤さんは、これからの未来についてはどんなことを考えているんですか?

後藤未来を語るには過去からの流れを振り返るとよいのですが、音楽は、昔から技術と共に発展してきています。今では当たり前のピアノやギターも発明当時は最新技術だったわけです。そんな風に、楽器もスピーカーも制作環境も配信手段も全部技術の力が支えています。つまり音楽という文化は技術の発展の影響を受けていて、その体験も技術とともにどんどん変化している。この変化が未来にも続かないわけがありません。

既に音楽のデジタル化が進んで大規模にクラウドに集積されたわけですが、従来は量的な変化、つまりコンテンツの数が増える変化が中心でした。でも、単にコンテンツを配って価値を生むことはだんだん難しくなっていきます。

私は、音楽のデジタル化がもたらす真の価値は、質的な変化、つまり体験の質が変わる変化だと10年以上前から論文に書いて主張していて、その変化を起こす鍵となるのが音楽理解技術だと考えています。それによって、「コピー不可能な能動的体験」を生むことが新たな価値を創っていきます。

さっき紹介した「リリックビデオ」の未来が「リリックアプリ」だ、というのがまさにその例なのですが、リリックビデオではみんな同じ映像を見ていたのが、リリックアプリでインタラクションを楽しみながら作品に触れると、その人ごとに違うコピー不可能な能動的体験になるわけです。

これが進むと、クリエイター側が最初から多様な体験を与える自由度のあるコンテンツ制作をするようになるかもしれません。

一方、聴いている側もコンテンツを自分好みに変化させるようになっていくかもしれません。今日紹介できなかった他の能動的音楽鑑賞インタフェースの事例では、私たちもいろいろと提案していたりします。

――聴いている側がそうやって好みでいじれるようになると、だんだん鑑賞と創作の境界が曖昧になっていく印象がありますね。

後藤それが私たちの目指してきた能動的な音楽鑑賞です。ユーザーはただ受け身でコンテンツを消費するだけの存在じゃない。音楽鑑賞もクリエイティブな体験になっていくわけです。

だから私たちのKiiteでは最初から、ユーザーを「リスナー」とは位置づけずに、楽曲を他の人にお勧めする「キュレーター」と位置づけて明記しています。自分が好きな音楽を見つけて、そのプレイリストを作って共有して紹介し合い、さらにそれをみんなと一緒に聴く、という行為は充分にクリエイティブで、未来ではそれも表現や創作のカタチとして当たり前になっていくと思います。

そういう意味でも、さきほど紹介したようにKiite Cafeのファンの人たちが私たちの思いもしなかったすごくクリエイティブな応援をしてくれたことは、一緒に未来を切り拓いている同士のように感じられて、本当に嬉しかったんです。

Kiite Cafe 3周年を祝うユーザーたち。

Kiite Cafe 3周年を祝うユーザーたち。

――創作と鑑賞とコミュニケーションが全部融合して新しい体験になっていく感じがしますね。

後藤そうやって、人間のクリエイティブな活動と技術の発展の両輪で、音楽の楽しみ方がより能動的で豊かになる質的な変化を起こしていければ、音楽の体験や文化はもっと豊かになっていくはずだと信じています。

今回は技術の力で新しい音楽体験の未来を拓いていく研究者、後藤真孝さんにお話しを伺いました。

非常に多岐にわたる大量の研究成果があり、長いお話しになりましたが、実際のところこれでもまだ全部紹介しきれておらず面白い技術が色々とカットされています。

他にも後藤さんが関わった産総研のサービスに、ニコニコ動画上のオリジナル楽曲の動画が星になり、派生動画がその衛星になって回る星図「Songrium」があります。

Songriumにはニコニコ動画の人気コンテンツがいつの時代にどう盛り上がっていたかを追体験できる「超歴史プレーヤー」という機能もあり、これはニコニコ動画に浸って生きてきたオタクには懐かしく、配信者の話すニコニコネタが分からないと嘆く最近の若い人には非常に便利な楽しいコンテンツです。ぜひこれも機会があれば触って見て欲しいと思います。

Kiiteなどのサービスも含め、後藤さんたちが取り組んでいるのは、コンテンツとの出会いであり、私たちを幸せにする新しい体験です。

これらの技術は人々に体験してもらって初めて価値を生むものです。ぜひこの機会に後藤さんたちが公開しているサービスに触れて楽しんでもらえたら幸いです。

最後に、今回の記事で紹介した技術やサービスは、後藤さんをはじめ様々な研究者やエンジニア、関係者の方々の貢献によって達成された成果です。その方たちのクレジットを記載させていただきます。

関連文献

[TextAlive]

[リリックアプリ / TextAlive App API]

[SmartMusicKIOSK]

[Songle]

[V-Sido × Songle / Songle Widget]

[Songle Sync]

[Kiite]

[Kiite Cafe]

[Kiite World]

[VocaListener]

[Songrium]

[能動的音楽鑑賞インタフェース]

- Masataka Goto: Active Music Listening Interfaces Based on Signal Processing, Proceedings of the 2007 IEEE International Conference on Acoustics, Speech, and Signal Processing (IEEE ICASSP 2007), pp.IV-1441-1444, April 2007.

- Masataka Goto and Roger B. Dannenberg: Music Interfaces Based on Automatic Music Signal Analysis: New Ways to Create and Listen to Music, IEEE Signal Processing Magazine, Vol.36, No.1, pp.74-81, January 2019.

ナゾロジーおすすめ記事リンク

人間情報インタラクション

研究部門

後藤 真孝

Goto Masataka